É impossível ignorar o crescimento da IA na cibersegurança. Modelos de linguagem grandes (LLMs), como o GPT-4, ganharam destaque, aparecendo em tudo, desde assistentes de código até ferramentas de segurança. Os testes de penetração, tradicionalmente um processo lento e manual, estão agora a passar por uma revolução impulsionada pela IA. De facto, num estudo recente, 9 em cada 10 profissionais de segurança afirmaram acreditar que a IA acabará por assumir os testes de penetração. A promessa é atraente: imagine a meticulosidade de um pentester experiente combinada com a velocidade e a escala de uma máquina. É aqui que entra o conceito de “Pentest GPT”, que está a mudar a forma como pensamos sobre segurança ofensiva.

Mas o que é exatamente o Pentest GPT? E, igualmente importante, o que ele não é? Antes de imaginar um script ChatGPT glorificado a hackear sistemas magicamente, vamos esclarecer o termo e explorar como os LLMs estão a ser incorporados no processo de pentesting. Também analisaremos os limites rígidos dos pentests alimentados por GPT – desde alucinações de IA até lacunas de contexto – e por que a experiência humana continua sendo vital. Por fim, veremos como a abordagem Aikido (nossa plataforma contínua de pentest baseada em IA) lida com esses desafios de maneira diferente, com validação humana, resultados fáceis de usar para desenvolvedores e integração CI/CD. Vamos mergulhar com uma visão calma e pragmática nesta nova era de testes de penetração assistidos por IA.

O que «Pentest GPT» realmente significa (e não significa)?

“Pentest GPT” refere-se à aplicação de modelos de linguagem do tipo GPT a fluxos de trabalho de testes de penetração. Em termos simples, trata-se de usar um cérebro de IA para emular partes do trabalho de um pentester – desde mapear caminhos de ataque até interpretar resultados de varredura. No entanto, não é tão simples quanto pegar o ChatGPT, vestir um capuz de hacker e esperar um teste de penetração completo a partir de um único comando. A distinção é importante.

Modelos gerais como o ChatGPT são treinados com textos amplos da Internet e certamente podem explicar conceitos de segurança ou debater ataques, mas, por padrão, carecem de conhecimento especializado em segurança ofensiva. Eles não foram criados com um conhecimento profundo de estruturas de exploração, bases de dados CVE ou o fluxo de trabalho passo a passo que um pentester real segue. Em contrapartida, um verdadeiro sistema Pentest GPT é normalmente ajustado para segurança. É treinado com dados selecionados, como relatórios de vulnerabilidades, manuais de equipas vermelhas, código de exploração e relatórios reais de pentest. Esta especialização significa que ele «fala» a linguagem das ferramentas e técnicas de hacking.

Outra diferença importante é a integração. O Pentest GPT não é apenas um chatbot isolado – ele geralmente está conectado a ferramentas de segurança e fontes de dados reais. Por exemplo, um Pentest GPT bem projetado pode ser conectado a scanners e frameworks (Nmap, Burp Suite, Metasploit, etc.) para que possa interpretar os seus resultados e recomendar os próximos passos. Ele funciona como uma camada inteligente entre as ferramentas, sem substituí-las completamente. Uma analogia útil de um comentário: o ChatGPT pode fornecer um bom resumo do que é injeção SQL, enquanto o Pentest GPT pode orientá-lo a encontrar uma injeção SQL ativa em um site, gerar uma carga útil personalizada, validar a exploração e até mesmo sugerir uma correção posteriormente. Em resumo, o Pentest GPT é mais do que apenas “ChatGPT + um prompt = pentest”. Implica um assistente de IA desenvolvido especificamente para compreender o contexto da pirataria informática e agir de acordo com ele.

Também vale a pena notar o que o Pentest GPT não é. Não é um hacker mágico de um clique que torna todas as outras ferramentas obsoletas. Nos bastidores, ele ainda depende do arsenal habitual – scanners, scripts e exploits –, mas usa o LLM para unir tudo. Pense nele como um amplificador para automação: ele adiciona raciocínio e contexto aos resultados brutos que as ferramentas automatizadas tradicionais produzem. E, apesar do nome atraente, o “PentestGPT” na prática não é um único produto ou modelo de IA, mas uma categoria crescente de abordagens. Os primeiros protótipos, como o PentestGPT (um projeto de investigação de código aberto) e AutoPentest-GPT demonstraram testes em várias etapas guiados pelo GPT-4, e plataformas de segurança estabelecidas (como Aikido) agora estão incorporando o raciocínio alimentado por GPT em seus motores de pentest. O campo está evoluindo rapidamente, mas a ideia central permanece: usar LLMs para tornar pentest automatizado e mais semelhante ao pensamento humano.

Como os LLMs (como o GPT-4) são usados em testes de penetração

Os testes de penetração modernos envolvem mais do que executar um scanner e gerar um relatório. Testadores experientes encadeiam várias etapas — desde o reconhecimento até a exploração e pós-exploração —, muitas vezes improvisando com base no que encontram. Os LLMs estão a se mostrar hábeis em auxiliar (ou mesmo executar de forma autónoma) várias dessas fases. Aqui estão algumas das principais funções que a IA baseada em GPT desempenha no processo de testes de penetração:

1. Raciocínio de caminho: ligando os pontos entre vulnerabilidades

Uma das habilidades mais poderosas de uma IA como o GPT-4 é planejar ataques em várias etapas, quase como um estrategista humano. Por exemplo, um scanner de vulnerabilidades típico pode informar que «o servidor X está a executar um serviço desatualizado» e, separadamente, que «o banco de dados do utilizador tem credenciais padrão fracas». Cabe a um pentester humano perceber que essas duas descobertas podem ser combinadas: fazer login no banco de dados com credenciais padrão e pivotar para explorar o servidor desatualizado para obter acesso mais profundo. Os LLMs se destacam nesse tipo de raciocínio. Um Pentest GPT pode automaticamente conectar os pontos em um caminho de ataque, identificando que uma cadeia de problemas de menor gravidade, quando usados em conjunto, pode levar a um comprometimento grave (por exemplo, direitos de administrador de domínio ou controle total do aplicativo). Essa síntese do “quadro geral” é algo que as ferramentas baseadas em regras raramente fazem, mas um modelo GPT pode, em virtude de sua compreensão contextual. Na prática, isso significa que as ferramentas de pentest baseadas em IA podem fornecer narrativas de ataque, não apenas descobertas isoladas. Elas explicam como uma pequena configuração incorreta mais uma chave API vazada podem se transformar em uma violação crítica, dando aos desenvolvedores e equipes de segurança uma visão muito mais clara dos riscos.

2. simulação de ataques: Criação e execução de exploits

LLMs como o GPT-4 também são usados para simular ações de invasores durante um teste de penetração. Isso vai além de apenas apontar uma vulnerabilidade – a IA pode ajudar a executar as etapas de exploração (de maneira controlada). Por exemplo, se o sistema suspeitar de uma injeção SQL num formulário web, um agente de IA pode gerar uma carga útil personalizada para esse formulário específico e tentar recuperar dados. Se encontrar uma injeção de comando, pode tentar gerar um shell ou extrair informações confidenciais, tal como um humano faria. O modelo pode recorrer ao seu treino (que inclui inúmeros exemplos de exploração) para criar strings de entrada ou pedidos HTTP em tempo real. Essa capacidade de se adaptar e criar cargas de ataque poupa muito trabalho manual de scripting. Essencialmente, permite que a IA atue como desenvolvedora e operadora de explorações. Igualmente importante, um bom Pentest GPT validará o efeito da exploração — por exemplo, confirmando que o SQLi realmente despejou o banco de dados ou que a injeção de comando permite a execução remota de código — em vez de confiar cegamente na sua primeira tentativa. Na plataforma Aikido, por exemplo, assim que um agente descobre um problema potencial, ele executa automaticamente verificações e cargas adicionais para provar que a descoberta é explorável, garantindo que o resultado não seja um falso alarme. Esse tipo de simulação de ataques impulsionada por IA aproxima muito mais os testes automatizados do que um invasor humano criativo faria: tentar algo, ver a resposta, ajustar as táticas e passar para a próxima etapa.

3. Passos em cadeia: ataques adaptativos em várias etapas

O pentesting raramente é uma tarefa de uma única etapa; é uma cadeia de ações e reações. Os LLMs estão a ser usados para orquestrar cadeias de ataques em várias etapas de forma adaptativa. Considere um cenário: um agente de IA começa com o reconhecimento, encontra algumas portas abertas e uma credencial vazada e, em seguida, usa a lógica alimentada por GPT para decidir o próximo passo — talvez usar a credencial para fazer login, executar uma exploração de escalonamento de privilégios no sistema de destino e assim por diante. Ao contrário das ferramentas tradicionais que seguem um script fixo, um sistema guiado por LLM pode tomar decisões em tempo real. Se uma via for bloqueada (por exemplo, um login falha ou um serviço não é explorável), ele pode mudar dinamicamente de rumo e tentar um caminho diferente, tal como um humano faria. Os investigadores descrevem isso como uma abordagem “agênica ”: vários agentes de IA lidam com diferentes tarefas (reconhecimento, varredura de vulnerabilidades, exploração, etc.) e passam informações uns aos outros, coordenados pelo raciocínio do LLM. O resultado é um teste de penetração automatizado que mantém o contexto entre as etapas e aprende à medida que avança. Por exemplo, descobertas em estágio inicial (como uma lista de funções de utilizadores ou um esquema de API) podem informar ataques posteriores (como testar o controlo de acesso baseado em funções). O raciocínio em linguagem natural do GPT-4 ajuda aqui, interpretando dados não estruturados (documentos, mensagens de erro) e incorporando esse conhecimento em explorações subsequentes. Essa capacidade de encadeamento era tradicionalmente um domínio exclusivo dos humanos. Agora, os agentes de IA podem lidar com muitas dessas transições lógicas: reconhecimento → exploração → pós-exploração → limpeza, encadeando várias técnicas para atingir um objetivo. É claro que não é infalível — lógicas de negócios complexas ou novos caminhos de ataque ainda podem atrapalhar uma IA —, mas é um grande salto em termos de capacidade. Notavelmente, é assim que o teste de penetração de IA Aikidofunciona: dezenas ou centenas de agentes invadem o alvo em paralelo, cada um focando em ângulos diferentes, e o sistema usa um cérebro impulsionado por LLM para coordenar o seu progresso através de uma cadeia de ataque (descoberta, exploração, escalonamento de privilégios, etc.). O resultado é um exercício muito mais completo, em que a IA pode escalonar as descobertas passo a passo, em vez de parar numa lista interminável de problemas separados.

Limites dos testes de penetração com tecnologia GPT: alucinações, lacunas de contexto e o fator humano

Com todo o entusiasmo em torno pentest de IA, é importante abordar os limites e explicar por que os humanos ainda não estão fora do circuito. Os LLMs são poderosos, mas têm fraquezas bem documentadas que são importantes no contexto da segurança. Aqui estão algumas limitações importantes dos testes de penetração «alimentados por GPT» e por que especialistas humanos experientes ainda desempenham um papel crucial:

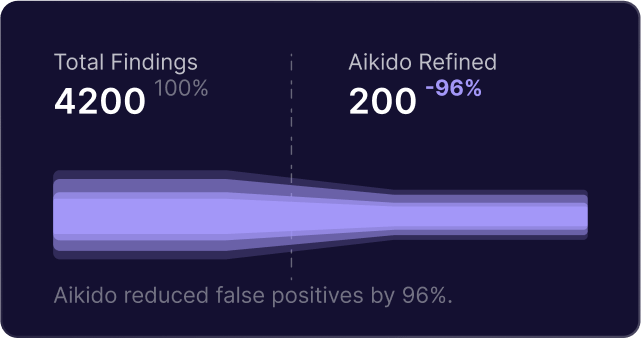

- Alucinações e falsos positivos: os modelos GPT às vezes produzem informações que parecem plausíveis, mas são incorretas — um fenómeno conhecido como alucinação. Em testes de penetração, isso pode significar que uma IA sinaliza incorretamente uma vulnerabilidade que na verdade não existe ou interpreta erroneamente um comportamento benigno como malicioso. Por exemplo, um GPT pode inventar um «CVE-2025-9999» fictício com base nos padrões que observou ou concluir erroneamente que um sistema é vulnerável porque espera uma determinada resposta. Esses falsos positivos podem desperdiçar tempo e minar a confiança na ferramenta. É necessária uma validação rigorosa para combater isso. (No sistema Aikido, por exemplo, nenhuma descoberta é relatada até que seja validada por uma exploração ou verificação real — a plataforma executa novamente o ataque ou testa a carga útil automaticamente para garantir que o problema seja reproduzível.) Esse tipo de proteção é essencial porque um LLM, se não for verificado, pode acabar se convencendo de que encontrou fantasmas.

- Falta de contexto profundo ou conhecimento atualizado: o conhecimento de um LLM é limitado pelos seus dados de treino. Se o modelo não tiver sido atualizado recentemente, poderá deixar passar vulnerabilidades ou técnicas recém-divulgadas — por exemplo, uma exploração publicada no mês passado não será conhecida por um modelo treinado no ano passado. Além disso, os GPTs não conhecem inerentemente o contexto específico da sua aplicação. Eles não têm a intuição ou familiaridade que um testador humano pode desenvolver após explorar manualmente uma aplicação durante dias. Se não for fornecido contexto suficiente (como código-fonte, documentação ou credenciais de autenticação), um agente de IA pode ignorar falhas lógicas sutis ou interpretar mal a importância de certas descobertas. Essencialmente, o GPT tem um amplo conhecimento de segurança, mas não possui um conhecimento profundo sobre o seu ambiente. Fornecer mais contexto à IA (como conectar o código do repositório ou descrições do fluxo do utilizador) pode mitigar isso, mas ainda existe uma lacuna entre saber muitas informações gerais e realmente compreender um sistema de destino personalizado. Essa é uma das razões pelas quais o julgamento humano ainda é crucial — um testador experiente pode identificar anomalias ou problemas de lógica de negócios de nível superior que uma IA não sintonizada com o negócio pode não compreender. (Dito isto, curiosamente, quando a IA Aikidorecebe código e contexto, ela até descobre vulnerabilidades lógicas complexas, como desvios de fluxo de trabalho em várias etapas, que os testadores humanos não perceberam. O contexto é fundamental tanto para a IA quanto para os humanos.)

- Confiança excessiva em padrões: As IAs tradicionais de pentest podem basear-se em padrões de ataque e manuais conhecidos. Se algo estiver fora desses padrões, a IA pode ter dificuldades. Por exemplo, um mecanismo de segurança inovador ou uma implementação criptográfica invulgar podem confundir o modelo, enquanto um humano pode investigá-lo de forma criativa. O GPT-4 certamente pode generalizar e até mesmo ser criativo, mas no final das contas ele segue os padrões estatísticos do seu treinamento. Isso significa que vulnerabilidades em casos extremos ou falhas altamente específicas de aplicações (pense no abuso de um recurso de aplicação de uma forma que ninguém escreveu publicamente) são mais difíceis de serem encontradas. Os humanos, com sua intuição e capacidade de lidar com ambiguidades, ainda se destacam na descoberta dessas questões estranhas e pontuais.

- Restrições éticas e de âmbito: uma consideração prática – os modelos GPT não conhecem inerentemente os limites éticos ou as restrições de âmbito de um teste de penetração, a menos que sejam explicitamente controlados. Um pentester humano está ciente de não interromper a produção, evitar a destruição de dados, etc. Um agente autónomo pode precisar de barreiras de proteção rígidas (e, de facto, boas plataformas fornecem configurações de modo seguro e definições de escopo para manter os agentes de IA no alvo e não destrutivos). Embora isso seja mais uma questão de design da plataforma do que uma falha no próprio GPT, isso ressalta que a supervisão humana é necessária para garantir que a IA opere com segurança e dentro das regras de engajamento acordadas.

- A Necessidade de Interpretação e Orientação Humana: Finalmente, mesmo quando a IA faz tudo certo, muitas vezes é preciso um humano para interpretar os resultados para decisões estratégicas. Por exemplo, decidir quais vulnerabilidades realmente importam para o negócio ou fazer um brainstorming sobre como um atacante poderia explorar uma descoberta além do que foi feito automaticamente pode exigir o toque humano. Há também o aspecto da confiança – muitas organizações querem que um especialista em segurança humano revise um relatório de pentest gerado por IA, tanto para verificá-lo quanto para traduzi-lo em termos de negócios quando necessário. A IA pode gerar muitos dados; a expertise humana é necessária para priorizar e planejar a remediação em um contexto de programa de segurança mais amplo.

Em resumo, o pentest com tecnologia GPT é um multiplicador de força em vez de um substituto para os humanos. Ele pode lidar com o trabalho pesado de ataques rotineiros, cobrir mais terreno e fazê-lo continuamente. Mas os humanos ainda definem os objetivos, lidam com os casos novos e fornecem julgamento crítico sobre o risco. Como uma observação colocou, os melhores resultados vêm quando o GPT é combinado com ferramentas determinísticas e supervisão humana – a IA realiza o raciocínio e a geração de relatórios, enquanto as ferramentas e as pessoas garantem a validação confiável. A maioria das equipes que adota o pentest de IA o utiliza como uma camada fundamental e depois adiciona revisão humana para a etapa final. Dessa forma, você obtém a eficiência da IA e a sabedoria de especialistas humanos trabalhando em conjunto.

A Abordagem da Aikido: pentest de IA Contínuo com um Toque Humano

Na Aikido Security, abraçamos a IA no pentest através de nossa plataforma (chamada Aikido “Attack”), mas o fizemos com atenção cuidadosa aos limites acima. O objetivo é aproveitar os LLMs para o que eles fazem de melhor – velocidade, escala e raciocínio – enquanto mitigamos suas fraquezas. Veja como os pentests impulsionados por IA da Aikido diferem de um script básico de “Pentest GPT” ou de ferramentas automatizadas tradicionais:

- Testes Contínuos e Sob Demanda (Integração CI/CD): A Aikido permite que você execute testes de penetração sempre que precisar – mesmo a cada alteração de código. Em vez de um pentest anual de grande impacto, você pode integrar testes de segurança impulsionados por IA em seu pipeline de CI/CD ou implantações de staging. Isso significa que novos recursos ou correções são testados imediatamente, e a segurança se torna um processo contínuo em vez de um evento único. Nossa plataforma é construída para os fluxos de trabalho dos desenvolvedores, então você pode acionar um pentest em um pull request ou agendar execuções noturnas. Quando seu aplicativo vai para produção, ele já passou por uma série de testes impulsionados por IA. Essa abordagem contínua aborda a lacuna de velocidade onde o código geralmente muda diariamente, mas os pentests manuais acontecem raramente. Com agentes de IA, os testes acompanham o desenvolvimento.

- Resultados Validados e Livres de Ruído: Reconhecemos que a saída de uma IA precisa de verificação. O motor de pentest da Aikido possui validação integrada em cada etapa. Quando a IA suspeita de uma vulnerabilidade, ela não a relata imediatamente – ela lança um agente de validação secundário para reproduzir o exploit de forma limpa e confirmar o impacto. Apenas problemas comprovados e exploráveis chegam ao relatório final. Este design significa que você obtém praticamente zero falsos positivos (se um problema não for confirmado, ele não é relatado) e nosso sistema protege ativamente contra alucinações de IA sobre vulnerabilidades. O resultado é que os desenvolvedores não são bombardeados com alertas de “possível problema” ou descobertas especulativas – eles veem falhas de segurança reais e confirmadas com evidências. Essa abordagem une a criatividade do GPT com a cautela de um testador humano: cada descoberta é essencialmente verificada duas vezes, para que você possa confiar na saída.

- Visibilidade Total e Saída Amigável para Desenvolvedores: O pentest de IA da Aikido não opera como uma caixa preta. Oferecemos visibilidade total sobre o que os agentes de IA estão fazendo – cada requisição, payload e tentativa de ataque pode ser observada ao vivo em nosso dashboard. Isso é crucial para a confiança e o aprendizado do desenvolvedor. Você pode ver por que uma vulnerabilidade foi sinalizada e como ela foi explorada, desde rastreamentos de requisição/resposta até capturas de tela do ataque em andamento. Os resultados finais vêm em um relatório pronto para auditoria que inclui todos os detalhes técnicos (endpoints afetados, etapas de reprodução, timestamps), bem como descrições de risco em linguagem simples e orientações de remediação. Nosso objetivo é tornar a saída amigável para desenvolvedores: em vez de uma vaga “Vulnerabilidade no módulo X”, você obtém uma explicação clara do problema, como reproduzi-lo e como corrigi-lo. Vamos ainda um passo além – nossa plataforma inclui um recurso AutoFix que pode pegar certas descobertas (como uma injeção de SQL ou injeção de comando detectada) e gerar automaticamente um pull request Git com as alterações de código propostas para corrigir o problema. Os desenvolvedores podem revisar essa correção gerada por IA, mesclá-la e, em seguida, fazer com que a Aikido reteste o aplicativo imediatamente para verificar se a vulnerabilidade foi resolvida. Esse ciclo encontrar→corrigir→retestar apertado significa remediação mais rápida e menos idas e vindas. Tudo isso é feito de uma forma que os desenvolvedores podem facilmente digerir, evitando jargões de segurança ou saídas brutas intermináveis do scanner. Trata-se de tornar os resultados do pentest acionáveis.

- Expertise Humana no Ciclo: Embora nossos agentes de pentest operem autonomamente, não removemos o elemento humano – nós o aumentamos. Primeiro, o próprio sistema foi treinado e ajustado com a contribuição de testadores de penetração seniores, codificando seus fluxos de trabalho e conhecimento. Mas além disso, incentivamos e apoiamos a validação humana onde ela é importante. Muitos clientes da Aikido usam as descobertas da IA como linha de base e, em seguida, pedem à sua equipe de segurança ou a um analista da Aikido para fazer uma revisão rápida, especialmente para aplicativos críticos. Nossa experiência mostrou que a IA detectará a grande maioria dos problemas técnicos (e até muitas falhas lógicas complicadas) por conta própria. No entanto, sabemos que a segurança é, em última análise, sobre defesa em profundidade – então uma verificação humana de sanidade pode adicionar garantia, e facilitamos a colaboração em torno dos resultados da IA. Além disso, se a execução da IA não encontrar nada crítico (o que é uma ótima notícia), as organizações têm tranquilidade com nossa política de que “Zero Descobertas = Custo Zero” para certos engajamentos. Essa garantia reflete nossa confiança na exaustividade da IA, mas também garante que, se um humano mais tarde encontrar algo que a IA perdeu, você não pagou por um teste incompleto. Em suma, a abordagem da Aikido combina automação de IA com opções de supervisão humana para oferecer o melhor dos dois mundos.

- Controle de Segurança e Escopo: O Aikido Attack foi construído pensando nas necessidades empresariais, então adicionamos controles robustos para manter a IA no caminho certo. Antes de um pentest de IA ser executado, você define o escopo exato: quais domínios ou IPs são alvos permitidos, quais estão fora dos limites (mas podem ser acessados em modos somente leitura), detalhes de autenticação e até janelas de tempo para testes. A plataforma os impõe com um proxy integrado e verificações de “pré-voo” – se algo estiver mal configurado ou fora do escopo, o teste não prosseguirá, evitando acidentes. Há também um “botão de pânico” instantâneo para interromper os testes imediatamente, se necessário. Essas medidas garantem que um teste autônomo nunca sai do controle e apenas realiza ações seguras e acordadas, muito parecido com um pentester humano diligente. Para mais informações sobre como protegemos seu ambiente, consulte a arquitetura de segurança da Aikido.

No geral, a solução de pentest impulsionada por IA da Aikido aborda a promessa do Pentest GPT enquanto resolve suas armadilhas. Você obtém pentest contínuo e inteligente que pode pivotar e raciocinar através de ataques como um humano, sem a espera ou o custo típicos dos testes manuais. Ao mesmo tempo, você não obtém o ruído usual da automação – cada descoberta é real e vem com contexto. E você ainda tem a opção (e nós a incentivamos) de envolver engenheiros de segurança para validação final ou para lidar com os casos de borda, garantindo que nada passe despercebido. É uma aplicação equilibrada e pragmática da IA: use a máquina para o que ela faz de melhor (velocidade, escala, reconhecimento de padrões) e deixe os humanos fazerem o que eles fazem de melhor (pensamento criativo e julgamento de cenário geral). O resultado final é um processo de pentest que é mais rápido e mais frequente, mas também completo e confiável.

Do Hype à Realidade: Experimente o pentest com IA Você Mesmo

Explore recursos e ferramentas externas referenciados nesta abordagem:

- Nmap – Mapeador de rede de código aberto usado para reconhecimento.

- Burp Suite – Scanner de vulnerabilidades web e proxy usado em muitos pentests impulsionados por IA.

- Metasploit – Framework de teste de penetração para desenvolvimento e execução de exploits.

- Banco de Dados CVE (NVD) – O Banco de Dados Nacional de Vulnerabilidades para rastreamento de falhas de segurança.

- PentestGPT GitHub – Projeto de pesquisa Pentest GPT de código aberto.

- Projeto AutoPentest-GPT – Framework de pentest automatizado construído com tecnologia GPT.

Para ver como você pode trazer o pentest contínuo e inteligente para sua organização, comece a usar Aikido em 5 minutos ou leia histórias de sucesso de clientes sobre organizações que já estão reduzindo riscos com IA.

Para mais conteúdo educacional sobre desenvolvimento seguro, DevSecOps e IA em segurança, navegue pelo Blog da Aikido.

A IA não substituirá os especialistas em segurança humanos – mas tornará seu trabalho mais eficiente e ajudará as organizações a proteger o software em um ritmo que corresponda ao desenvolvimento moderno. Os LLMs estão provando que podem assumir grande parte do trabalho pesado de teste de penetração, desde vasculhar um aplicativo em busca de fraquezas até escrever exploits e compilar relatórios. Como discutimos, o termo Pentest GPT significa essa nova geração de ferramentas que fundem o raciocínio da IA com o conhecimento de hacking. Não é apenas hype; já está remodelando como os pentests são feitos, transformando um processo anual em uma prática contínua e amigável para desenvolvedores.

Se você está curioso para ver isso em ação, por que não experimentar o pentest de IA da Aikido? Oferecemos uma maneira de executar um pentest gratuito e self-service em seu próprio aplicativo para experimentar como os agentes autônomos trabalham em conjunto com seu ciclo de desenvolvimento. Em minutos, você pode configurar um teste e observar os agentes de IA sondarem sistematicamente seu aplicativo – com total transparência e controle. Você receberá um relatório detalhado em horas (não semanas), e pode até integrá-lo ao seu pipeline de CI para que cada novo lançamento seja testado automaticamente. É uma chance de testemunhar como os conceitos do Pentest GPT – raciocínio de caminho, exploração inteligente, validação de resultados – se unem em um produto real.

Dica profissional: Você pode iniciar um pentest impulsionado por IA na Aikido gratuitamente (não é necessário cartão de crédito) ou [saiba mais em nosso site] sobre como funciona. Estamos confiantes de que, uma vez que você veja a IA encontrar e corrigir vulnerabilidades na velocidade da máquina, concordará que esta é uma maneira mais tranquila e inteligente de manter seu software seguro.

Em resumo, a IA veio para ficar na cibersegurança. A chave é usá-la com sabedoria. Pentest GPT, como conceito, trata de aumentar a expertise humana com as capacidades incríveis da IA – não substituí-la. A missão da Aikido é entregar pentests contínuos impulsionados por IA com validação humana integrada, para que você possa identificar problemas cedo, frequentemente e com confiança. À medida que a indústria evolui, aqueles que combinam a eficiência da IA com a engenhosidade da inteligência humana estarão mais bem posicionados para proteger seus sistemas contra o cenário de ameaças em constante mudança. O futuro do pentest está sendo escrito agora – e está sendo escrito em parte pelo GPT-4.

(Interessado em dar o próximo passo? Você pode começar um pentest de IA em 5 minutos na plataforma da Aikido ou agendar uma demonstração para ver como ele se encaixa no seu fluxo de trabalho DevSecOps. Os testes de segurança não precisam ser lentos ou isolados – com as ferramentas de IA certas, ele se torna uma parte contínua do desenvolvimento, capacitando sua equipe a construir e lançar software com tranquilidade.)

Proteja seu software agora