O Relatório Internacional de Segurança da IA 2026é uma das visões gerais mais abrangentes até à data sobre os riscos apresentados pelos sistemas de IA de uso geral. Foi compilado por mais de 100 especialistas independentes de mais de 30 países e mostra que, embora os sistemas de IA estejam a funcionar a níveis que pareciam ficção científica há apenas alguns anos, os riscos de uso indevido, mau funcionamento e danos sistemáticos e transfronteiriços são evidentes.

Apresenta argumentos convincentes a favor de uma melhor avaliação, transparência e salvaguardas. Mas uma questão direta continua por explorar: o que significa «seguro» quando a IA opera de forma autónoma contra sistemas reais?

Um resumo das conclusões interessantes do Relatório Internacional sobre Segurança da IA inclui:

- Pelo menos 700 milhões de pessoas utilizam sistemas de IA semanalmente, com taxas de adoção mais rápidas do que as dos computadores pessoais nos seus primeiros anos.

- Várias empresas de IA lançaram os seus modelos para 2025 com medidas de segurança adicionais, depois de testes pré-implantação não terem conseguido descartar a possibilidade de os sistemas ajudarem não especialistas a desenvolver armas biológicas. (!!!) (Não está claro se as medidas de segurança adicionais ainda assim impediriam totalmente isso.)

- Equipes de segurança documentaram o uso de ferramentas de IA em ataques cibernéticos reais, tanto por agentes independentes quanto por grupos patrocinados por governos.

O relatório discorre longamente sobre as abordagens para gerir muitos dos riscos associados à IA – eis a nossa opinião:

Onde Aikido com o relatório (e maneiras de ir além)

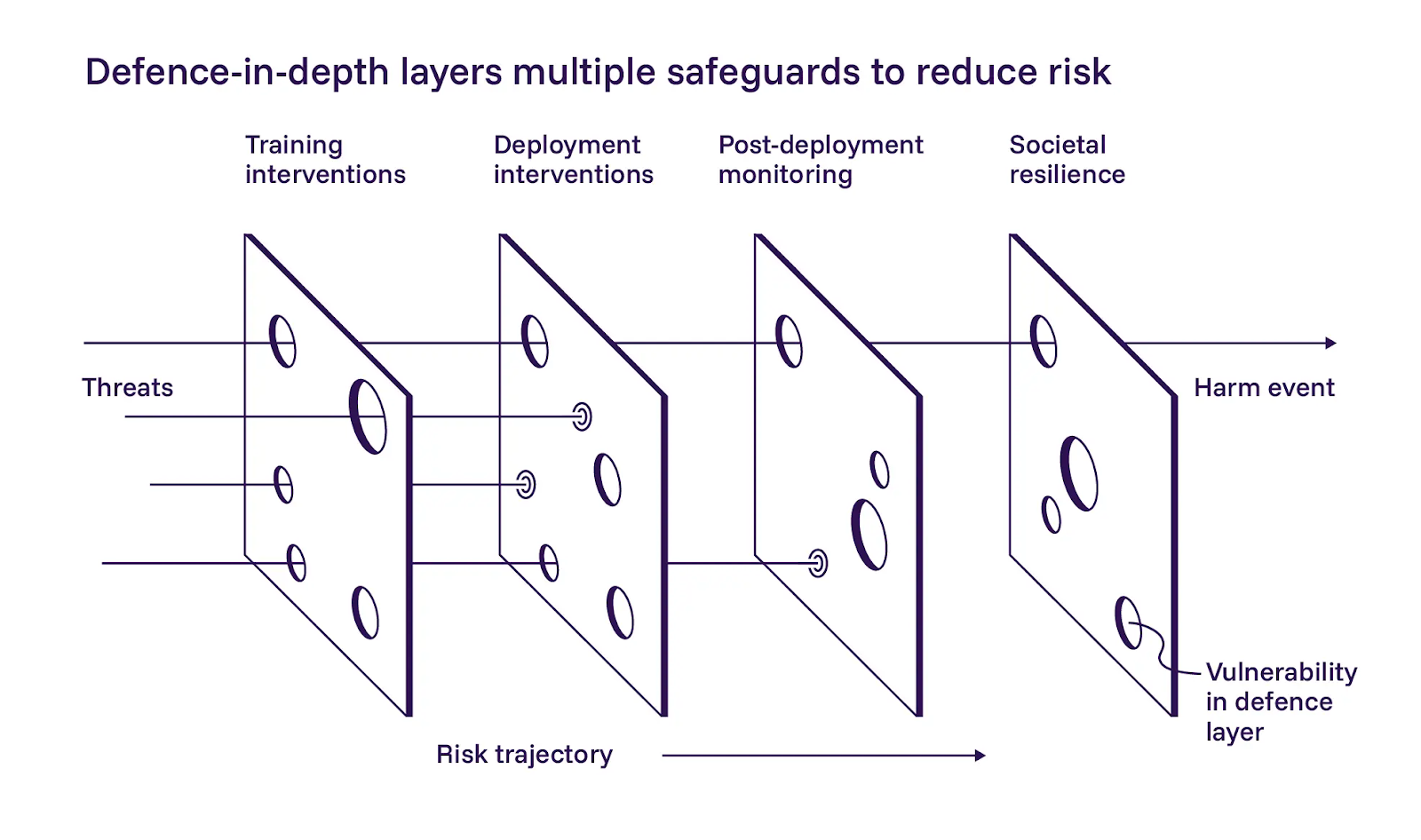

1. A defesa em camadas é importante

O relatório descreve uma abordagem de defesa em profundidade para a segurança da IA, dividindo-a em três camadas: construir modelos mais seguros durante o treinamento, adicionar controlos na implementação e monitorizar os sistemas após a sua entrada em funcionamento. Concordamos amplamente com a aplicação dessas camadas.

O relatório enfatiza a primeira camada, o desenvolvimento de modelos mais seguros. Eles estão cautelosamente otimistas de que as mitigações baseadas em treinamento podem ajudar, mas também reconhecem que são difíceis de implementar em grande escala. Embora concordemos que os operadores de IA devem dar o seu melhor durante o treinamento, a nossa filosofia diverge ligeiramente do relatório neste caso. Não podemos confiar em prompts ou instruções para manter os sistemas agênicos dentro do escopo. A defesa em camadas só funciona se cada camada puder falhar independentemente.

2. Validação como requisito de segurança

O relatório não entra em detalhes sobre a implementação da segunda camada, os controlos no momento da implementação, mas acreditamos que é aí que os progressos mais imediatos podem ocorrer.

O Relatório Internacional documenta modelos que manipulam as suas avaliações de formas preocupantes. Alguns encontram atalhos que obtêm boas pontuações nos testes sem realmente resolver o problema subjacente (reward hacking). Outros apresentam um desempenho intencionalmente inferior quando detectam que estão a ser avaliados, tentando evitar restrições que pontuações altas podem acionar (sandbagging). Em ambos os casos, os modelos otimizam para algo diferente do objetivo pretendido.

Chegámos à mesma conclusão: uma vez que os sistemas de IA operam de forma autónoma, não se pode confiar no que eles próprios relatam, nos seus níveis de confiança ou nos seus traços de raciocínio. Um agente que valida as suas próprias descobertas cria um único ponto de falha disfarçado de redundância. A operação segura requer tratar as descobertas iniciais como hipóteses, reproduzir o comportamento antes de relatar e usar uma lógica de validação separada da descoberta. Essa validação pode até vir de outro agente de IA.

3. Reduza o risco antes de permitir que os agentes sejam executados em ambientes ativos

A terceira camada do relatório abrange observabilidade, controlos de emergência e monitoramento contínuo a entrada em funcionamento dos sistemas. Isso está em consonância com o que observamos nas nossas operações.

A operação em caixa preta não é aceitável para sistemas autónomos que interagem com a infraestrutura de produção, por isso tratamos os mecanismos de paragem de emergência como requisitos inegociáveis. Se não consegue ver o que um agente está a fazer ou pará-lo quando ele sai dos trilhos, não está a operá-lo com segurança, independentemente da qualidade do modelo subjacente.

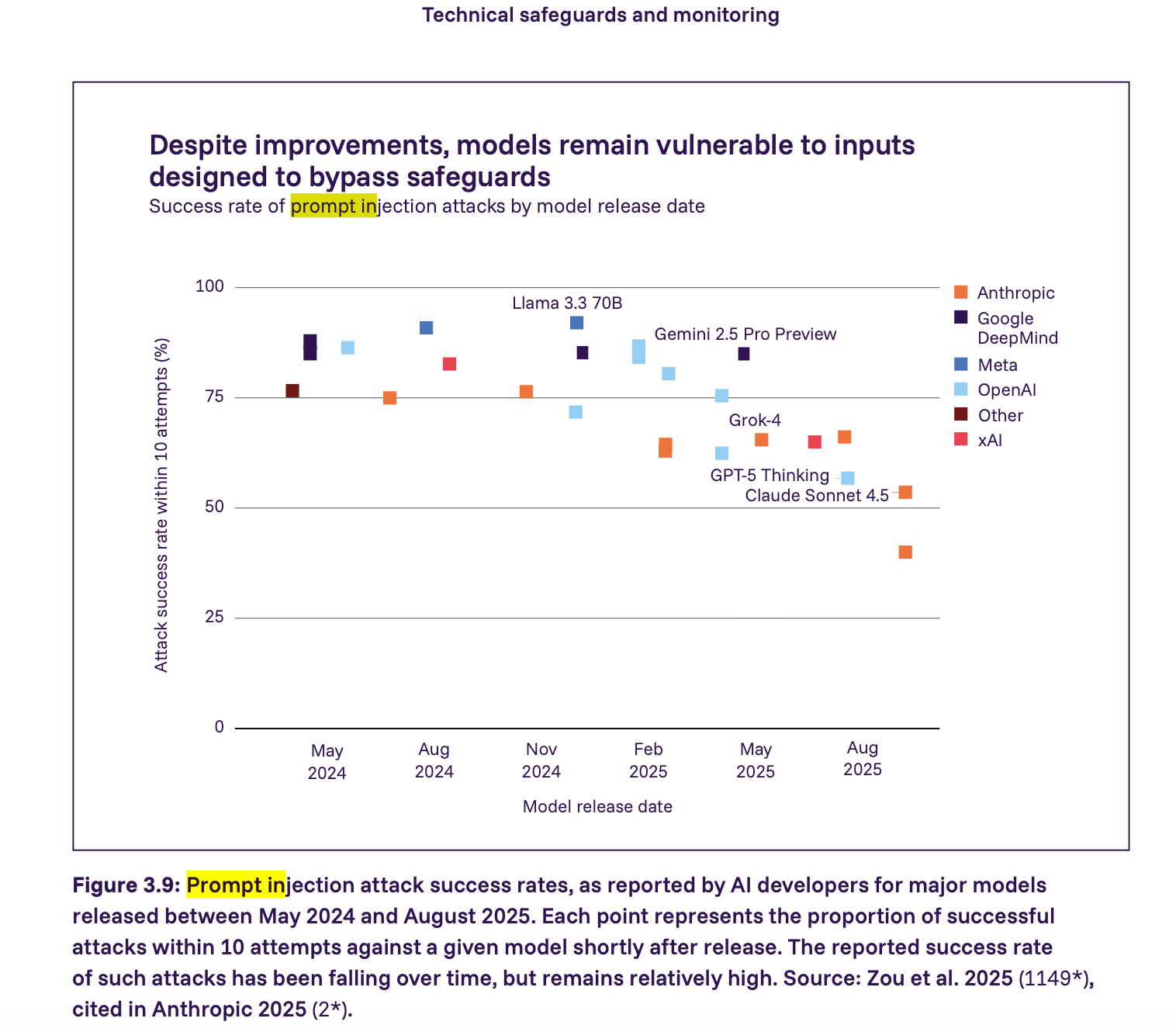

4. A injeção imediata requer restrições impostas, não esperança

O relatório mostra que os ataques de injeção imediata ainda são uma vulnerabilidade grave – muitos modelos importantes em 2025 poderiam ser atacados com sucesso por injeção imediata com relativamente poucas tentativas. A taxa de sucesso está a diminuir, mas continua relativamente alta. Vamos um passo além do relatório e afirmamos que qualquer agente que interaja com conteúdo de aplicativos não confiáveis deve ser considerado vulnerável à injeção imediata por padrão. A segurança, neste contexto, vem da aplicação de restrições e não da esperança de que os modelos se comportem corretamente.

O que achamos que deve acontecer a seguir

Sistemas, não apenas modelos

O relatório defende veementemente a defesa em profundidade, a transparência e a avaliação. Esses aspetos são importantes, mas muitos dos problemas mais imediatos ocorrem quando os modelos se conectam a ferramentas, credenciais e ambientes ativos. É por isso que os requisitos no nível da implementação são tão importantes (e necessários). Temos de traduzir esses princípios em requisitos técnicos concretos que as equipas possam implementar.

Com base na operação pentest de IA em produção, acreditamos que os requisitos mínimos de segurança para sistemas de IA autónomos devem incluir:

- prevenção de abusos validação de propriedade

- Controlo de âmbito reforçado ao nível da rede

- Isolamento entre raciocínio e execução

- Observabilidade total e controlos de emergência

- Garantias de residência e processamento de dados

- Contenção imediata da injeção

- Validação e controlo de falsos positivos

Descobrimos que estes são os requisitos mínimos exigíveis para a segurança. Se omitir qualquer um deles, introduz um risco inaceitável no sistema. Aprofundamos estes requisitos na nossa publicação do blogue sobre pentest de IA .

Referências de segurança como alicerces das políticas

O Relatório Internacional sobre Segurança da IA representa um progresso significativo no sentido de um entendimento comum dos riscos da IA entre governos, investigadores e indústria. O desafio agora é fazer a ponte entre os resultados da investigação, os quadros regulamentares e as práticas de implementação no mundo real.

O relatório apresenta alguns cenários realmente preocupantes e estatísticas inquietantes sobre a rapidez com que as capacidades estão a avançar. Dito isto, isso não é motivo para entrar em pânico ou regulamentar a «IA» como um monólito assustador. O próprio relatório observa que as salvaguardas variam muito entre os desenvolvedores e

que mandatos prescritivos podem sufocar a inovação defensiva. Concordamos. A regulamentação deve evitar impor um único caminho de implementação. Em vez disso, as políticas devem definir bases de segurança claras e orientadas para resultados, que possam servir de alicerces para estruturas mais amplas.

Como parte do movimento para criar estruturas de segurança mais focadas em resultados, publicámos o nosso documento sobre os Requisitos Mínimos de Segurança para Testes de Segurança Orientados por IA. Para equipas que avaliam pentest de IA ou constroem sistemas de segurança autónomos, este guia serve como uma referência independente de fornecedores. Esperamos que isso ajude as equipas a avaliar pentest de IA , construir sistemas de segurança autónomos mais seguros e contribuir para o estabelecimento de bases claras que funcionem tanto para construtores quanto para reguladores.