Quando é que pentest de IA é pentest de IA seguro para ser executado em sistemas reais?

Se você se sente desconfortável com os testes de penetração de IA, não está atrasado. Provavelmente está à frente.

Os testes de segurança são uma das primeiras áreas em que a IA já não está apenas a ajudar os humanos, mas a agir por conta própria. pentest de IA modernos pentest de IA exploram aplicações de forma independente, executam ações reais e adaptam-se com base no que observam.

Isso é poderoso. Também levanta questões muito reais sobre controlo, segurança e confiança.

Este post não é sobre se pentest de IA . É sobre quando é realmente seguro executá-lo.

Por que o ceticismo em relação ao pentest de IA razoável

A maioria dos líderes de segurança com quem falamos não é contra a IA. Eles são cautelosos, e por bons motivos.

Eles preocupam-se com coisas como:

- Perder o controlo sobre o que está a ser testado

- Agentes que interagem com sistemas de produção acidentalmente

- O ruído abafa as questões reais

- Dados confidenciais a serem tratados de forma pouco clara

- Ferramentas que se comportam como caixas pretas, sem poderem explicar internamente o seu funcionamento

Essas preocupações são válidas, especialmente porque muito do que é rotulado hoje comopentest de IAnão ajuda a construir confiança neste domínio.

Algumas ferramentas são DAST um LLM adicionado. Outras são sistemas baseados em listas de verificação, nos quais os agentes testam uma questão após a outra. Ambas as abordagens são limitadas e nenhuma delas prepara você para o que acontece quando os sistemas agem de forma autónoma.

Os verdadeiros testes de penetração de IA são diferentes, e essa diferença altera o nível de segurança.

O que muda com os testes de penetração com IA verdadeira

Ao contrário dos scanners ou ferramentas que seguem instruções, os verdadeiros sistemas de testes de penetração com IA:

- Tomar decisões autónomas

- Executar ferramentas e comandos reais

- Interaja com aplicações e APIs em tempo real

- Adaptar o seu comportamento com base no feedback

- Frequentemente executado em grande escala com muitos agentes em paralelo

Quando se atinge esse nível de autonomia, a intenção e as instruções não são mais suficientes. A segurança precisa ser garantida tecnicamente, mesmo quando o sistema se comporta de maneira inesperada.

Isso leva a uma pergunta simples.

O que é que pentest de IA «seguro» pentest de IA requer?

Com base na operação prática pentest de IA , começa a surgir uma linha de base clara. Estes são os requisitos que acreditamos que devem existir antes que pentest de IA considerado seguro para ser executado.

Esta lista é intencionalmente concreta. Cada requisito descreve algo que pode ser verificado, aplicado ou auditado, não um princípio ou uma prática recomendada.

1. Validação de propriedade e prevenção de abusos

pentest de IA só deve ser utilizado em ativos que o operador possua ou esteja explicitamente autorizado a testar.

No mínimo:

- A propriedade deve ser verificada antes do início dos testes.

- A autorização deve ser aplicada tecnicamente, não por meio de declarações do utilizador.

Sem isso, uma pentest de IA torna-se uma ferramenta de ataque geral. A segurança começa antes mesmo do primeiro pedido ser enviado.

2. Aplicação do âmbito ao nível da rede

Os agentes acabarão por se desviar. Este é um comportamento esperado, não um erro.

Por causa disso:

- Todas as solicitações de saída devem ser inspecionadas programaticamente.

- Os alvos devem ser explicitamente incluídos na lista de permissões

- Todos os destinos não autorizados devem ser bloqueados por predefinição.

A aplicação do escopo não pode depender de avisos ou instruções. Ela deve ocorrer no nível da rede, em cada solicitação.

Exemplo:

- Os agentes instruídos a testar um ambiente de teste às vezes tentam seguir links para a produção. Sem a aplicação da rede, esse erro atinge o destino. Com ela, a solicitação é bloqueada antes de sair do sistema.

3. Isolamento entre raciocínio e execução

Os sistemas de testes de penetração agênicos executam ferramentas reais, como comandos bash ou scripts Python. Isso introduz um risco de execução.

Os requisitos mínimos de segurança incluem:

- Separação rigorosa entre o raciocínio do agente e a execução da ferramenta

- Ambientes de execução em sandbox

- Isolamento entre agentes e entre clientes

Se um agente se comportar de forma inadequada ou for manipulado, a execução deve permanecer totalmente contida.

Exemplo:

- As tentativas iniciais de execução de comandos podem parecer bem-sucedidas, mas, na verdade, são executadas localmente. A validação e o isolamento impedem que esses resultados sejam mal interpretados ou se espalhem para além da área restrita.

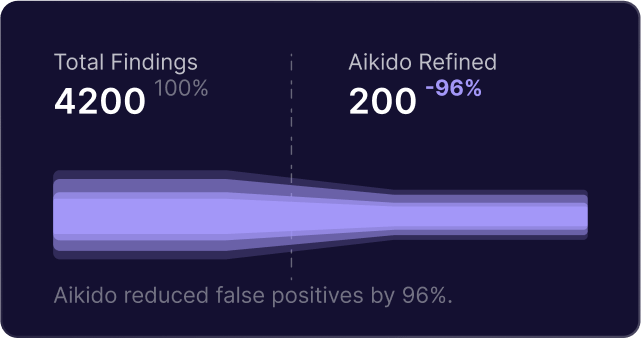

4. Validação e controlo de falsos positivos

Os sistemas autónomos irão gerar hipóteses erradas. Isso é esperado.

Um sistema seguro deve:

- Trate as conclusões iniciais como hipóteses

- Reproduza o comportamento antes de reportar

- Use uma lógica de validação separada da descoberta

Sem isso, os engenheiros ficam sobrecarregados com o ruído e os problemas reais passam despercebidos.

Exemplo:

- Um agente sinaliza uma potencial injeção SQL devido a respostas atrasadas. Uma etapa de validação reproduz a solicitação com cargas úteis variadas e rejeita a descoberta quando os atrasos não são consistentes.

5. Observabilidade total e controlos de emergência

pentest de IA não pentest de IA ser uma caixa preta.

Os operadores precisam ser capazes de:

- Inspecione todas as ações realizadas pelos agentes

- Monitorize o comportamento em tempo real

- Interrompa imediatamente todas as atividades se algo parecer errado.

Os mecanismos de paragem de emergência são um requisito básico de segurança, não uma funcionalidade avançada.

6. Garantia de residência e processamento de dados

pentest de IA lidam com dados confidenciais de aplicações.

Os requisitos mínimos incluem:

- Garantias claras sobre onde os dados são processados e armazenados

- Isolamento regional quando necessário

- Sem movimentação de dados entre regiões por predefinição

Sem isso, muitas organizações não podem adotar pentest de IA da capacidade técnica.

7. Contenção imediata da injeção

Os agentes interagem com conteúdo de aplicações não confiáveis por padrão. Deve-se esperar a injeção de prompts.

Os sistemas seguros devem:

- Restringir o acesso a fontes de dados externas não controladas

- Evite caminhos de exfiltração de dados

- Isolar ambientes de execução para que as instruções injetadas não possam escape

A injeção imediata não é um caso extremo. Faz parte do modelo de ameaças.

O que isto promete e não promete

Os sistemas autónomos, tal como os seres humanos, deixarão escapar algumas questões.

O objetivo não é a perfeição. O objetivo é identificar riscos materialmente exploráveis de forma mais rápida, segura e em maior escala do que os modelos de testes pontuais existentes.

Por que publicámos uma norma de segurança

Continuávamos a ter as mesmas conversas com as equipas de segurança.

Eles não estavam a pedir mais IA. Estavam a perguntar como avaliar se um sistema era seguro para ser executado.

Até que haja uma base comum, as equipas ficam na dúvida se pentest de IA estão a operar de forma responsável ou simplesmente assumindo que tudo está seguro.

Então, escrevemos o que acreditamos ser o mínimo necessário. Não é uma lista de verificação de produtos. Não é uma comparação. É um conjunto de requisitos aplicáveis que as equipas podem usar para avaliar ferramentas e fazer perguntas melhores.

Leia a Norma de Segurança Completa

Se desejar uma versão concisa e independente de fornecedores desta lista para partilhar internamente ou utilizar na avaliação de ferramentas, publicámos uma versão em PDF.

Também inclui um apêndice que mostra como uma implementação, Aikido , se adapta a esses requisitos de transparência.

Veja como isso funciona na prática

Se estiver curioso para saber como esses requisitos de segurança são implementados num pentest de IA real pentest de IA , também pode dar uma olhada no Aikido , a nossa abordagem para testes de segurança orientados por IA.

Foi construído para atender a essas restrições, com base no que se torna necessário quando pentest de IA operam em aplicações reais em grande escala.

Pode explorar como funciona ou usar esta lista para avaliar qualquer ferramenta que esteja a considerar.

Proteja seu software agora